En los PCs modernos de altas prestaciones, a la hora de jugar o de reproducir renderizados en 3D, tenemos unos molestos efectos en la pantalla, lo que se conoce como tearing, un vídeo demostrativo aquí. nVidia ha presentado un módulo hardware, para tratar de mejorar la visualización de imágenes en movimiento y eliminar en lo posible el tearing, el G-Sync.

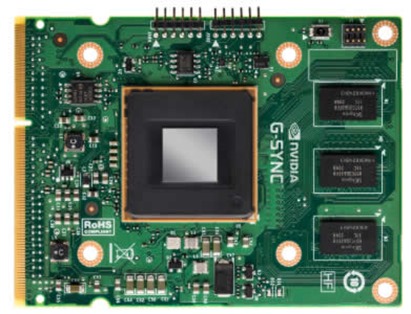

Como se puede deducir de la imagen superior, el G-Sync es un módulo de hardware. En teoría, debe ir instalado en el monitor, no en el PC. Lo que hace el G-Sync, es sincronizar la frecuencia de refresco del monitor en tiempo real, con la frecuencia de generación de cuadros de la tarjeta de vídeo. Actualmente, los monitores normalmente suelen trabajar a 60 imágenes por segundo (hercios). Pero la tarjeta de vídeo, según la complejidad de la secuencia de vídeo que esté representando, va variando su velocidad (los FPS de los tests de las gráficas). Eso produce descoordinación a la hora de mostrar las imágenes en el monitor y la aparición del tearing. Con este módulo, nVidia asegura que las imágenes se muestran en el monitor a la vez que son generadas por la tarjeta gráfica y suben o bajan de velocidad de forma automática.

Si esto funciona tal y como indica nVidia, será un gran avance no solo para los jugadores, sino para todas las aplicaciones de realidad virtual y de representación 3D en movimiento.

Actualmente se usa la tecnología V-SYNC para tratar de eliminar estos efectos. Se mejora mucho la visualización, pero no es perfecta y recarga de trabajo extra a la gráfica. Con G-Sync, esta tarea ya no la tendrá que realizar la tarjeta de vídeo. Los principales fabricantes de monitores ya están anunciando que presentarán equipos con este módulo montado en su interior. Veremos a que precios y que tal se portan. Eso si, solo funciona con gráficas nVidia con un Kepler en su interior, es decir como mínimo un GT 650 Ti Boost.

7 Comentarios

Comentarios Cerrados

en automoción los coches de ahora lleva de tres a cuatro sonda lambda, uno a la salida del gases del motor térmico, una a la salida del catalizador y otra a la salida del catalizador de los óxidos de nitrógeno. Usando estos datos. el motor sabe el resultado del trabajo que esta realizando continuamente verificaciones con uno resultado grabados en la uce.

De aquí mi pregunta. por ejemplo con mi monitor (que no es viejo), me vino un cd con un software, con esto puedo elegir configurado de dos formas diferentes, desde los botones que tiene o desde el software del cd (sin necesidad de tocar el monitor), aunque he probado y solo va por hdmi por dvi no vale (mandar datos para ordenar al monitor a subir o bajar el brillo por ejemplo (es un LG)

Eh de aquí el primer párrafo. no estaría bien un cable hdmi 1.4 de toda la vida y un cable usb 3.0 para que el monitor este sincronizado con la gráfica…… quien sabe a lo mejor hacen monitores exclusivos para amd y nvidia como hizo ps3, al sacar una tv para la consola en 3D

En realidad, yo diría que el HDMI ya sirve para comunicar datos, no haría falta tener otra conexión adicional.

No acabo de ver que esto sea tarea del monitor. De hecho, hoy día ya cualquier reproductor de vídeo decente selecciona el modo de vídeo que mejor se ajuste al vídeo a reproducir, y no sólo en resolución, sino ajustando los hz a los fps (por eso las TV de hoy día tienen el modo a 23.97 Hz, sincronizado con el cine). La única diferencia aquí es que esto se hace en tiempo real, ajustando los Hz en función de cuántos fps esté sacando el juego/aplicación de turno en un momento dado.

Como digo, no veo por qué hace falta aquí intervención del monitor, y de hecho es algo que se podría hacer ya mismo con cambios de código no muy importantes. Ahora bien, le veo una seria de problemas:

1) El cambio de modo no es instantáneo, y hacerlo en tiempo real, varias veces en pocos segundos, definitivamente se notaría. Igual por aquí viene la necesidad de hardware dedicado, para hacer más rápidos los cambios.

2) Me inquieta un poco que este tipo de técnicas no hagan que se descuide la optimización. Porque el problema de fondo aquí es que los fps fluctúen tanto, si un juego funcionase a 60 fps continuos no necesitaría este tipo de argucias.

Lo siento, pero no lo termino de ver. ¿No debería ser que en vez del hardware adaptarse al software, fuera éste el que se adaptara automáticamente a la frecuencia del monitor, o un divisor entero de ésta? Quicir: si puede ir a 60, generar 60, 30, 20 … imágenes por segundo.

Porque, francamente, si el monitor da de tope 60 y el ordenador da 90, se está tiranda a la basura un 50% del trabajo realizado. Pero eso sí, queda de P.M. chulear ante los colegas de que tu cuádruple xfire que consume 1KWh da 300fps con un monitor de 100Hz.

Pero eso se arregla activando el vsync, yo cuando jugaba, siempre tenía activado el vsync.

Pero este sistema justamente lo que hace es mejorar el v-sync

Lo que temo es el dolor de cabeza por frecuencias de actualización variables. Si FPS muy variables te pueden dar dolor de cabeza (a frecuencia de actualizacion constante), si sumas:

+Hz monitor variable

+guarri-LED PWM dimming

=tiras el monitor por la ventana

Nvidia debería poner LUTs mejores en sus gráficas gamer y dejarse de vendehumos.