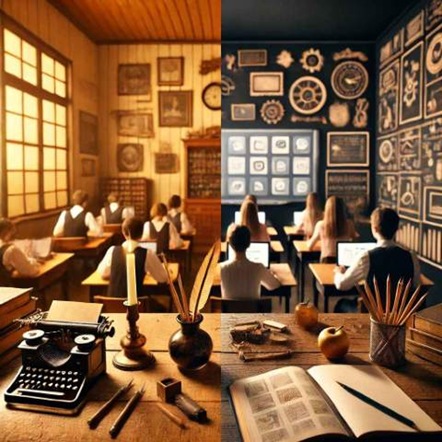

Estos días vemos un bandazo más de nuestros políticos que no se pueden estar quietos. Y sus asesores (como los consultores de mi antigua empresa de por la mañanas) van rotando los conceptos: antes era digitalizar la educación, ahora es volver al bolígrafo (ya puestos mejor una buena pluma de ganso, si retrocedemos hagámoslo bien) y al papel.

Pero yo hoy no venía a escribir sobre estas noticias con las que pretenden entretenernos mirando la punta del dedo y no veamos la luna de los errores en la educación de nuestros jóvenes. Tal vez otro día siga en esta línea, por cierto un artículo generalista que me ha gustado sobre este asunto este de Arcadi Espada en el Mundo.

Hoy yo venía a contar algunas experiencias con la IA estudiando en mi segunda época en la universidad. Como digo en el título son solo algunos experimentos: con algunos consigo mejorar y con otros no.

El año pasado no hice mucho uso de la IA, bastante tenía con ponerme al día en clase. Al final si que la estuve usando mucho como pequeño tutor rápido. Cuando estaba preparando mis esquemas o resúmenes y había cosas que no entendía o que los manuales, apuntes, jurisprudencia y códigos legales no se ponían de acuerdo. Solía funcionar bien. Conforme fue cogiendo más experiencia a la hora de lanzar mis consultas las respuestas eran mejores. Me di cuenta que acababa antes lanzando estas consultas en la IA que usando un buscado de internet. No tenía manías a la hora de usar varias IA. Iba compaginando Copilot, ChatGPT, Gemini, Llama… para estas tareas no notaba muchas diferencias.

Pero este año he subido un poco el nivel. En el primer cuatrimestre tenía una asignatura que siempre hacía un examen oral o escrito de desarrollo. Pero esta año cambiaron a un examen tipo test eliminatorio y luego un oral para cerrar la nota. Por otro lado como mis hijos usaban mucho más que yo la IA (algo también lógico ellos están estudiando carreras técnicas donde la aplicación directa de la IA parecía una opción más clara que en el oscuro derecho español que estudio yo) tras una rápida encuesta, empecé a pagar una licencia de ChatGPT Plus.

Con la asignatura que iban a introducir un examen tipo test empecé a prepararme con el ChatGPT. Me dediqué a realizar consultas sobre temas concretos y le pedía que me preparase tests con las mismas opciones que en el examen. Con un poco de prueba y error logré unas baterías de tests que me gustaban, parecían reales. El siguiente paso fue darle instrucciones a la IA para que me proporcionase los tests en un formato que pudiese importar desde Anki y que fuese compatible con el complemento Multiple Choice for Anki. Entonces fue creando baterías d tests de cada tema del examen, los pasaba a Anki y luego iba practicando. Lo bueno de Anki es su ubicuidad, podía hacer tests desde mi PC, desde el movil, desde una tableta… incluso podía conectarme vía Web desde un dispositivo que no fuese mío. La verdad que es algo muy tonto y simple… pero me permitió llegar al examen tipo test muy bien preparado. El uso continuado de Anki además de mejorar la memorización, aumentó mi velocidad de respuesta, algo importante ya que el tests era largo. Y no me llevó apenas tiempo preparar los tests gracias a la IA. Ni que decir que el examen tipo test fue un éxito.

Este cuatrimestre tengo otra asignatura que en los exámenes hay un apartado tipo tests y he repetido la estrategia y de momento también con buenos resultados.

Así que me puse a pensar en más cosas que pudiese hacer con la IA. Este cuatrimestre tengo otra asignatura con exámenes donde se mezcla la teoría y la práctica (una idea que me parece muy acertada para estudiar derecho). Tras ir haciendo prácticas de prueba en casa, pude configurar un cuadro resumen teórico de conocimientos básicos para ir más al grano a la hora de resolver el caso práctico. El problema es que ni en los manuales, ni en los textos legales, ni en los apuntes de clase esos conceptos aparecían claros y bien ordenados. En el primer parcial localicé más de 40 figuras jurídicas que eran candidatas a ser parte del examen. Podía hacerlo a mano, pero iba a tardar mucho tiempo. Así que recurrí a la IA. Y con esta tarea si que pude ver algunas diferencias entre aplicaciones. Plantee el tema de dos formas, una primera en la que les decía que buscasen en la red si hacía falta y les pasaba el prompt. En la segundo les proporcionaba como material de consulta los manuales de la asignatura, apuntes y códigos legales.

- ChatGPT en con licencia Plus: entendió bien lo que yo pretendía y comenzó a responderme con acierto… hasta que se paró. Cuando llevaba solo cuatro figuras jurídicas resumidas se detuvo. Tras insistir me mostró dos más… y de ahí no pude pasar. Pero si reducía la lista y en lugar de pedirle datos de 40, iba de 5 en 5, se paraba en la segundo y no daba más datos…

- Gemini en versión gratuita: fue peor, no entendía lo que deseaba. Con la misma entra que ChatGPT no obtenía datos congruentes. No logré sacar ningún resultado usable

- Copilot: la versión que viene con Office Home que no sé si será mucho mejor que la gratuita. La pasó lo mismo que a ChatGPT. Empezaba muy bien, me sacó una primera figura jurídica casi perfecta y me preguntó si quería que siguiese con las demás usando ese modelo. Le dije que si… 48 horas después tenía 8 conceptos más pero además cada vez iba empeorando el resultado.

- DeepSeek: ejecutándose en local en mi PC: no hubo forma de conseguir un resultado congruente. Demasiadas invenciones y datos erróneos en muchas partes del resumen

- Grok: versión gratuita: en 5 minutos tenía un resumen muy logrado. Empecé a repasarlo y no había ningún fallo. Eso ya sin material de apoyo. En la segunda pasada con el material de apoyo tardó un poco más y los resultados estaban más alineados al temario de la asignatura. El esquema que generó Grok se podía usar ya para estudiar y preparar las prácticas.

- Notebook de Google: esta versión especializada de Gemini solo podía funcionar en el modo alimentado. Subí los manuales, apuntes y códigos legales y le puse el mismo prompt que a los demás. Tardo unos 15 minutos, pero el resultado era todavía más equilibrado y completo que el del Grok. Al repasarlo en algunos conceptos del esquema se quedaba en blanco y decía que no había datos en el material. Pero si le hacías la preguntas concreta de ese apartado sin datos al Notebook si que te contestaba. Así que completé los cinco seis vacíos que dejó. Y al final monté un documento de Word con un formato esquemática con los datos de Notebook.

La conclusión es que si estás estudiando Derecho como es mi caso, la IA puede ser de gran ayuda aunque solo sea como un tutor al que hacer preguntas. Con Notebook logré el mejor equilibrio para que me ayudase a organizar material de estudio. Pero no solo eso, sino que resulta muy cómodo pedirle información y que te la muestre sobre todo el material que tienes de una asignatura. Lo he visto tremendamente útil y sencillo de usar. Y no le estoy sacando todo el partido por que el inglés oral no es lo mío. Miro con envidia a mis hijos (que no tienen problemas con el inglés) que se preparan el podcast que genera Notebook (solo en inglés) y se ponen a repasar los temas escuchando por los auriculares.

Así que la IA viene bien para estudiar. Y esto que estamos viendo es solo el principio.

2 Comentarios

Comentarios Cerrados

Por casualidad encontré un artículo hablando NotebookLM y se lo comenté a mi pareja que estaba estudiando un grado medio de FP. Desde entonces en cada asignatura en la que tiene sentido usarlo, ha ido grabando en audio las clases y creando cuadernos con dichos audios y el temario en PDF de cada examen. Los resúmenes y las guías de estudio le han servido de mucho e incluso lo usaba para comprobar las soluciones de los problemas que le planteaban en los ejercicios, que planteados como “prompt” llegaba a obtener respuestas desarrolladas a los mismos, no sólo el cálculo numérico.

El problema que tienen estas herramientas de IA en el mundo educativo es que obligan al profesorado y al propio sistema educativo a trascender el paradigma actual de mera comprobación de la memorización del temario en los exámenes (pa luego ya la comprensión y aplicación práctica de conceptos), obligando a usar métodos de evaluación que vayan más allá de un conjunto de test o preguntas a desarrollar en las que “volcar” la información sin más.

El uso que le doy yo, salvo que no paso los audios de clase, no me dejan grabarlos. Mis hijos además han puesto en algún caso vídeos de Youtube. Y estamos pensando en pagar la licencia para los dos meses finales de curso.

Y lo que indicas al final es la clave: cambiar la forma de aprender. Y va a ser compleja la adaptación.